Бесплатный seo анализ сайта онлайн

Содержание:

- Бонус

- Анализ внутренней оптимизации и поиск ошибок

- Пример хорошо продуманного функционала сайта

- Проверка сайта на мошенничество онлайн

- Проверяем домен на фильтры поисковых систем

- Лучшие инструменты для онлайн-анализа SEO сайта

- Немного о Яндекс тИЦ

- Сервисы анализа трафика

- 5 Экономия личного времени пользователя

- Визуальная проверка сайта на мошенничества

- Этапы разработки функционала сайта

- Немного о Google PR

Бонус

Если вы оцениваете привлекательность покупки сайта для клиента, можете оформить данные в подобный отчет:

site.ru

Данные домена/сайта

| Параметр | Данные | Комментарий |

| Доменная зона | ru | Хорошо |

| Индексация в Я и Г | 26000 | 13500 | Хорошо |

| Фильтры | нет | Сайт проверен на АГС, видимость сайта в поисковиках. АГС не обнаружен, других санкций, понижающих сайт в выдаче также не обнаружено (сайт занимает хорошие позиции в обоих поисковиках). |

| Возраст | 9,5 лет | Отлично. Взрослый сайт – хороший показатель |

| ТИЦ | 150 | Хорошо |

| Алекса Ранк | 280 899 | Хорошо |

| Архив сайта | С 2007 года домен находится у одного владельца. На домене с 2008 функционирует сайт для лам. Как и сейчас. | Отлично. Сайт имеет хорошую историю в одной тематике. |

| Зеркала, склейка | Главное зеркало: www.site.ru | Хорошо. Домен не склеен с другими. Имеющиеся показатели ТИЦ принадлежат ему |

| Количество входящих ссылок | 1709 ссылок с 343 доменов | Хорошо. Большинство ссылок естественные. Есть и купленные, но они хорошего качества – с тематичных статей. Анкор лист не переспамлен – анкоры весьма разнообразны. С данной ссылочной массой можно продолжать работать дальше (убирать ссылки не требуется) |

| Уникальность сайта | Средняя уникальность текстов сайта 19% | Проверено 140 страниц, уникальность на которых колеблется от 0 до 100%. В основном тексты неуникальны. Это плохо – сайт нуждается в повышении уникальности |

| Качество контента | Некоторые статьи весьма низкого качества, не оптимизированы | Проверено порядка 30 статей. Некоторые подробные с иллюстрациями, некоторые короткие и написаны не очень полно, не раскрывают вопроса полностью. Оптимизация статей (по явным признакам) не проводилась. Нужно будет перерабатывать контент. Но за счет этого можно хорошо увеличить трафик. |

| Движок сайта | Вордпресс | Хорошо — распространенный движок. Проблем с работой не возникнет. |

Трафик

Параметр

Данные

Комментарий

Посещаемость

9945

0,4 посетителя в день на страницу – плохой показатель. При активной работе над сайтом и увеличении % слов в ТОПе посещаемость может вырасти в разы

Динамика

начиная с 2008 года потихоньку растет. Резких падений не наблюдалось

Хороший показатель — сайт можно использовать для дальнейшего развития

Качество трафика

Основной трафик из поисковых систем. Трафик из Яндекса в два раза больше чем из Гугла

Сайт не имеет проблем с обоими ПС. Анализ показал, что разница объемов трафика связана с различной степенью интереса к тематике аудитории Яндекса и Гугла. При Большем количество запросов в ТОПе у Гугла, трафик больше все-таки у Яндекса

Это означает, что большая часть аудитории сайта сосредоточена в Яндексе и именно работе с этой поисковой системой стоит уделить большее внимание.

Позиции

15% ключевых слов, по которым сайт виден в поиске Яндекса находятся в ТОП-10 (21000 из 140000).

Порядка 20% ключевых слов в ТОП-10 Гугла

Работа по оптимизации и уникализации контента сайта позволит занять места в ТОПе намного большему количеству слов, что приведет к многократному росту трафика на сайт.

Конкуренты

Много

Для достижения новых высот придется активно бороться за место в ТОПе прилагая большое количество усилий

Вывод

Сайт не имеет проблем в виде фильтров, плохой ссылочной массы или проблем с индексацией. Имеет свою аудиторию и хорошую историю. Нуждается в повышении уникальности, переработке контента, работе по продвижению сайта. При правильном подходе способен увеличить трафик и прибыль в несколько раз.

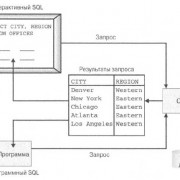

Анализ внутренней оптимизации и поиск ошибок

Подобные программы и сервисы, имитируя действия поисковых роботов, помогают найти критические ошибки сайта, которые будут мешать его индексации и негативно влиять на позиции. А также анализировать заголовки страниц, meta-теги, внутренние/внешние ссылки и так далее.

Screaming Frog SEO Spider

Подобно роботам поисковых систем, программа по внутренним ссылкам обходит все страницы сайта, изображения, файлы CSS, JavaScript и другие файлы. Собранная информация представлена в виде таблиц, в которых отражены основные характеристики найденных страниц и файлов. Заголовки и meta-теги, число входящих и исходящих ссылок, наличие тегов canonical и так далее. Данные могут быть экспортированы в Excel для дальнейшего анализа.

Пожалуй, лучшее приложение среди аналогов. Позволяет искать битые ссылки на сайте, внешние ссылки, редиректы, составлять и проверять XML-карты сайта, парсить сайт с разными User-Agent (проверка на клоакинг), искать страницы с заданным фрагментом HTML-кода и много другое. Есть полезный режим, в котором программа не обходит сайт, а анализирует заданный список страниц.

Есть бесплатная версия — она позволяет анализировать до 500 URL.

Netpeak Spider

Приложение, по функционалу похожее на Screaming Frog, но имеющее свои уникальные фичи. Позволяет определять 62 ошибки в 54 параметрах: битые ссылки, дубли страниц и текстов, дубли заголовков и meta-тегов, битые/бесконечные редиректы и многое другое.

ComparseR

Продвинутый краулер/парсер со множеством настроек и поддержкой регулярных выражений. Не только умеет сканировать сайты и искать ошибки, но также умеет парсить выдачу Яндекса и Google. Позволяет сравнить список проиндексированных поисковыми машинами страниц со списком страниц, полученных при парсинге сайта.

Бесплатная demo-версия парсит только первые 150 страниц сайта или 150 результатов выдачи.

SEOTO.ME

Парсер сайта в виде веб-сервиса от создателей программ CS Yazzle и CS Sape Master. Выявляет несуществующие и пустые страницы, ошибки в контенте, ошибки в заголовках и meta-тегах, битые картинки, битые ссылки и редиректы, рассчитывает PageRank.

Xenu’s Link Sleuth

Бесплатный и популярный в прошлом аналог Screaming Frog, но гораздо менее функциональный. Позволяет искать битые ссылки, отображает заголовки и описания страниц, число входящих и исходящих внутренних ссылок, тип и размер файлов, код ответа сервера. К сожалению, программа не развивается с сентября 2010 года.

Пример хорошо продуманного функционала сайта

HeadHunter (HH) — крупнейший в России сайт для размещения вакансий и поиска работы. Сюда приходят, чтобы найти подходящие вакансии, разместить резюме или предложения о работе. Посмотрим, реализован функционал этого сайта.

Ключевым элементом на главной странице стало поле для поиска работы — то, зачем пользователи приходят на HH. Если они настроены искать работу, собирая отклики на резюме, то могут воспользоваться кнопкой «Создать резюме».

А те, кому удобнее посещать сайт с мобильного устройства, могут сразу скачать приложение на свои смартфоны под iOS и Android. Разработчики не перегружали интерфейс лишними деталями, а использовали лишь те элементы, которые действительно полезны соискателям.

Главная страница HH

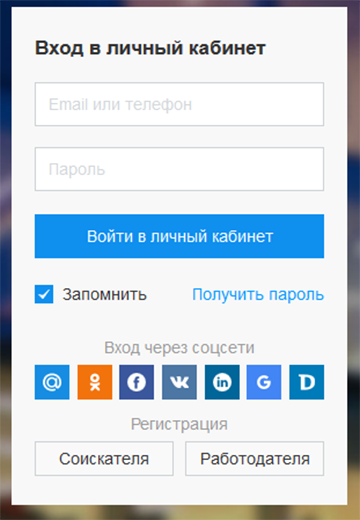

Форма входа в личный кабинет позволяет авторизоваться новым пользователям с помощью любой из семи популярных в России социальных сетей.

Вход в личный кабинет на сайте HH

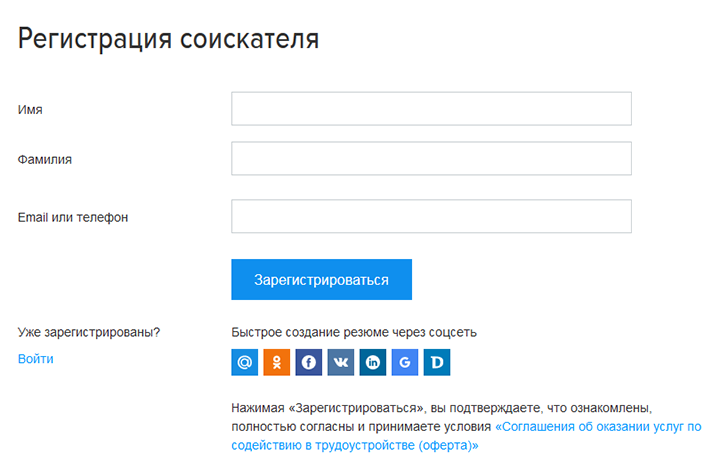

Соискателю при регистрации нужно заполнить минимум полей. Дополнительно соглашаться с условиями второй стороны, как это часто реализовано на других сайтах, не нужно. Для этого достаточно нажать кнопку «Зарегистрироваться».

Форма регистрации нового соискателя на сайте HH

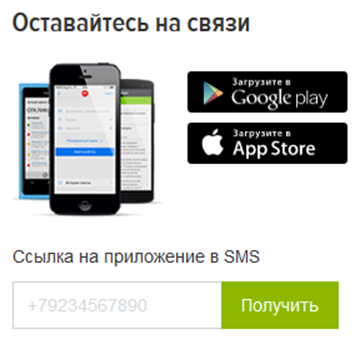

Если пользователю удобнее работать с сайтом на мобильном устройстве, можно запросить ссылку на скачивание приложения из Google Play и App Store. Владельцы сайта попутно решают еще одну задачу — получают соглашение на отправку SMS оповещений. Соответствующий блок можно увидеть, прокрутив главную страницу на несколько окон вниз.

Форма отправки ссылки на мобильное приложение для HH

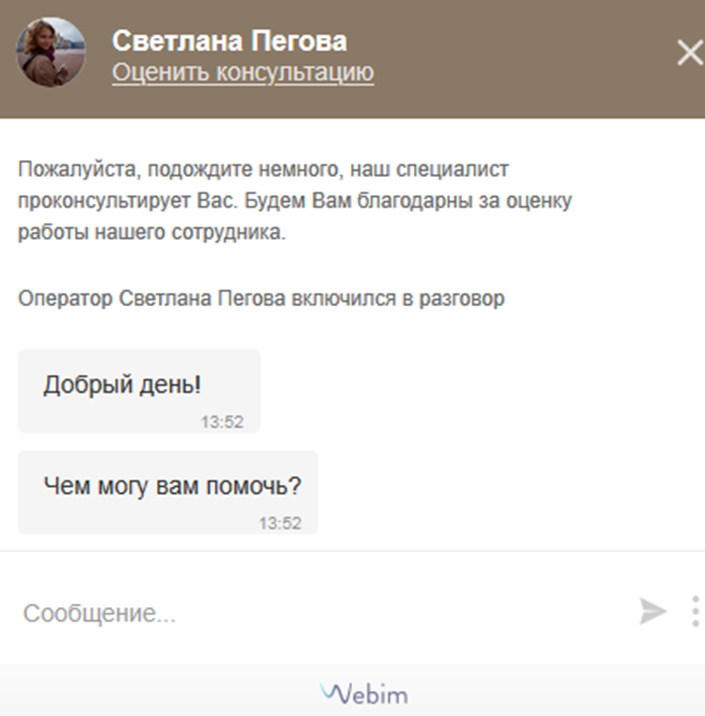

Задать вопрос сотруднику проекта можно в онлайн-форме, которая вызывается кнопкой «Помощь», размещенной вверху страницы. Дополнительно представляться или вводить контактные данные не нужно, таким образом, пользователь может сразу обратиться за помощью, не совершая лишних действий.

Форма связи с онлайн-консультантом на сайте HH

Чтобы каждый раз не сортировать вакансии от более новых к старым, для постоянных посетителей сайта на главную страницу вынесен блок с лучшими предложениями дня.

Блок с новейшими вакансиями на сайте HH

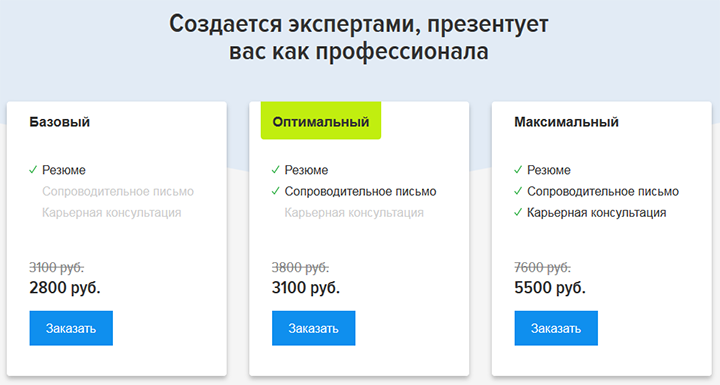

Для тех, кто хочет делегировать составление резюме специалистам, есть платная услуга — «Готовое резюме», ссылка на которую доступна в нижней части главной страницы HH. Здесь пользователю предлагают три варианта взаимодействия, которые отличаются перечнем услуг и стоимостью. Можно увидеть, что входит в тарифный план, и сразу оформить заказ.

Форма заказа резюме от экспертов на сайте HH

Проверка сайта на мошенничество онлайн

Интернет ведет активную борьбу со злоумышленниками. В сети имеется множество специализированных ресурсов, направленных на проверку и разоблачение фейковых сайтов. Всего можно насчитать 4 основных сервиса, при помощи которых проводится webproverka подозрительных порталов на самые разные способы мошенничества.

VirusTotal online

VirusTotal online — сервис для проверки загружаемых файлов на вирус. Если непроверенный сайт предлагает пользователю скачать «необходимую» для работы программу, то первое, что нужно сделать — проверить файл на VirusTotal.

Максимальный размер: 128 мб. В случае обнаружения вредоносного ПО, сервис покажет соответствующую надпись.

Google Safe Browsing

Google Safe Browsing — система защиты, автоматически установленная на современных браузерах Google , Opera и Safari. Сервис предоставляет интернет-провайдерам адреса с низкой трастовостью из черного списка, после чего на экран пользователя высвечивается соответствующее сообщение.

Пользователь может перейти на ресурс, если согласится взять на себя ответственность.

Web of Trust (WoT)

Web of Trust (WoT) — надстройка к браузеру для проверки траста. Сервис реализован системой сообщества — каждый участник выставляет свою оценку ресурсу, после чего программа рассчитывает среднее значение. Этот ресурс предупреждает пользователя о сайтах с низкой трастовостью, то есть уровнем доверия и авторитета среди поисковых систем.

На способность сайта трастовостить оказывают влияние такие факторы:

- индексация;

- показатели Google PR и Яндекс ТИЦ;

- исходящие ссылки;

- уникальность контента;

- скорость загрузки сайта;

- история домена;

- возраст сайта.

Пример трастовой проверки социальной сети vk.com. Ресурс проводя, траст сайта, определяет степень доверия и уровень безопасности для детей.

WebMoney Advisor

WebMoney Advisor — расширение для браузера от разработчиков электронной системы оплаты Webmoney. Приложение в автоматическом режиме проверяет открываемые пользователем ресурсы и, в случае опасности, выводит сообщение на экран.

Прочие программы для проверки сайта на мошенничество

Указанные примеры — уникальные и полезные ресурсы, однако в интернете имеется ряд аналогов, которые менее распространены, но по функционалу не уступают.

Список приложений:

- McAfee WebAdvisor — по функционалу схож с Google Safe Browsing. Отличительной чертой является способность автоматически исправлять опечатку в адресе web-сайта.

- Comodo Web Inspector — осуществляет всестороннюю проверку веб-портала, из-за чего процесс сканирования может занять продолжительное время. После завершения пользователь увидит подробную информацию о портале. В том числе и IP-адрес, на который он зарегистрирован.

- PhishTank — это сборник всех сайтов-мошенников, которые имеются в сети. Сервис собирает данные из WoT и Google Safe Browsing и отображает общий индекс доверия.

- StopBadware — используется веб-мастерами с целью выяснить, входит ли их url в черный список поисковиков. Может быть использован для определения лжи и обычным юзером.

- Mirzam WebProverka — сканирует IP, дату регистрации и использование защищенных соединений.

- Avast Online Security — защищает пользователя от фишинга. Приложение сканирует каждый сайт и предупреждает, если он не соответствует безопасности. База данных формируется за счет пользователей. На 2021 год их более 400 млн.

Указанные приложения просты в установке, проверены временем и сотрудничают с популярными организациями — Google , Avast и другими.

При запуске одной из подозрительных или неизвестных программ проверьте ее через VirusTotal. Нередко вредоносное ПО проникает на компьютеры через файлы антивирусов.

Как проверить ссылку на уникальность

Для проверки ссылки на безопасность можно использовать любой из многочисленных online -ресурсов. Самым популярным и достоверным принято считать сервис URL Analysis.

Для работы достаточно вставить ссылку на сайт в поисковое поле и нажать кнопку «URL Analysis».

Проверяем домен на фильтры поисковых систем

Владелец домена или работающего сайта с тем или иным доменным именем в прошлом мог нарушать правила, установленные поисковыми системами. Обычно это приводит к санкциям ресурса или, как их еще принято называть, попаданию под фильтры.

Google и Яндекс (самые популярные ПС в России) могут выдавать URL-адресам фильтры по разным причинам:

- копирование чужого контента;

- насыщение текстов ключевыми словами;

- добавление в материалы скрытого текста;

- продажа ссылок в больших объемах;

- манипулирование поведенческими факторами;

- установка на сайте агрессивной рекламы;

- наличие вирусов;

- продвижение проектов «серыми» или «черными» схемами.

Выше перечислены основные причины. На самом деле их больше, требования поисковиков всегда меняются. Поэтому я раз в 1-2 месяца проверяю актуальность, чтобы вносить нужные поправки на свои ресурсы.

Проверка по ИКС, трафику и количеству страниц в индексе

В первую очередь, при анализе домена стоит обратить внимание на трафик. Проверку можно провести через Яндекс.Метрику, Google Analytics или Liveinternet

Если трафик находился долгое время на одном уровне, а затем резко сократился, это первый признак «фильтра» на домене. Конечно, причины могут быть и другие, поэтому требуется дополнительная проверка.

Для этого я сопоставляю фактическое количество страниц (оцениваю, сколько статей на сайте, это делается простым серфом по категориям проекта) на сайте с индексацией в поисковой системе. Для этого захожу в ПС и ввожу «site:www.site.ru» (пробелы не надо ставить):

В данной ситуации все хорошо, гуглом проиндексировано много страниц, поэтому фильтры явно отсутствуют. Подобную проверку нужно сделать и в Яндексе.

В завершении я проверяю ИКС сайта. Для этого пользуюсь инструментом от «BE1». В поле «Домены для проверки» указываю интересующий меня адрес и запускаю проверку. Если ИКС равен 0 или выше, то все ок, фильтров, скорее всего нет. Если же вижу надпись «не определен», значит у домена есть какие-то проблемы.

Проверка брендовых запросов

Вышеописанный анализ не всегда позволяет выявить скрытые проблемы проекта и домена в частности. Я рекомендую дополнительно проводить проверку по брендовому запросу, а именно по доменному имени сайта.

Для этого захожу в Яндекс и Google, ввожу там запрос типа «site ru» (без точки с пробелом). В нормальной ситуации сайт с соответствующим адресом будет находиться на первом месте. Если же его там нет, значит, имеют место скрытые проблемы.

Уведомления в панелях вебмастера

Самый верный и контрольный способ – проверить наличие ограничений через Яндекс.Вебмастер и Google Search Console.

В первом случае (сервис Яндекса) я сначала проверяю вкладку «уведомления». Если какой-либо фильтр был применен ручным способом, то там появится соответствующее оповещение. После просматриваю раздел «Диагностика сайта». Здесь нужно смотреть пункт «Обнаружены нарушения или проблемы с безопасностью»:

В панели Google ситуация обстоит аналогичным образом. Для начала нужно проверить страницу с уведомлениями об ошибках на сайте:

После этого я смотрю раздел «Меры, принятые вручную». Если домен хороший, то на странице будет сообщение «Проблем нет»:

Если там есть сообщения об ограничениях на проекте, то лучше отказаться от покупки.

Дополнительная проверка с Xtool

Чтобы наверняка убедиться в качестве рассматриваемого доменного имени, я дополнительно провожу проверку через простой и удобный сервис Xtool. Он автоматически определяет наличие санкций от Яндекса и выдает результат в таблице:

Бывают ситуации, когда в момент покупки фильтра нет, но после совершения сделки он внезапно выстреливает. Алгоритмы Xtool анализируют ссылочную базу проекта и делают вывод: возможно ли в ближайшее время получение санкций:

Если вы столкнетесь с подобной ситуацией, то лучше отказаться от покупки такого домена и ресурса в целом, потому что исправление ссылочной базы – задача непростая и требует много времени и сил.

Для проверки фильтров «Панда» и «Пингвин» от Google я использую иностранный сервис Barracuda:

Сервис выдает статистику по трафику сайта. Вертикальные линии – моменты обновления алгоритмов поисковой системы. Если после линии видно резкое снижение трафика, значит, сайт попал под действие какого-либо фильтра и его лучше не покупать.

Лучшие инструменты для онлайн-анализа SEO сайта

SEO ― совокупность работ, которая направлена на повышение позиций сайта в поисковой выдаче. Чем выше сайт в выдаче поиска, тем чаще его видят пользователи и тем больше шансов привлечь потребителей на сайт.

Так же как и при изучении посещаемости, выбор сервисов для анализа зависит от того, чей сайт вы изучаете. Если вы хотите проанализировать свой сайт, то самыми популярными сервисами являются Яндекс.Вебмастер и Google Search Console. Если ваш ресурс создан на REG.Site, настроить базовое SEO-продвижение поможет статья Как настроить SEO-продвижение сайта, созданного в REG.Site.

Проанализировать сторонний ресурс помогут другие сервисы. Ниже мы сделаем обзор наиболее популярных сервисов, с помощью которых можно сделать онлайн SEO-анализ сайта бесплатно.

XTOOL

XTOOL позволяет быстро сделать комплексный SEO-анализ сайта бесплатно.

С его помощью можно узнать:

возраст сайта,

рейтинг веб-ресурса в поисковых системах,

наличие санкций на сайт,

количество внутренних и внешних ссылок,

показатели PR, ИКС, ТИЦ,

траст.

SBUP.com

По сравнению с XTOOL SBUP.com имеет более широкий функционал. Кроме стандартных SEO-параметров (возраст, PR, ИКС и ТИЦ-показатели, ключевые слова, внутренние и внешние ссылки), он показывает:

IP-адрес,

тип и ПО сервера,

наличие вирусов,

скорость ресурса,

определяет примерную цену.

PR-CY

PR-CY.RU ― один из самых популярных бесплатных сервисов, с помощью которого можно проверить оптимизацию сайта.

Введите интересующий вас домен и сервис покажет вам:

важные изменения, которые происходили на сайте, например изменения в файле robots.txt,

ИКС, PR, позиция в Яндекс и Google,

вирусы и санкции,

посещаемость,

рейтинг в Alexa.

В платной версии можно получить ещё больше информации:

географию аудитории,

источники трафика,

поведение пользователей (количество отказов, время на сайте, количество посещенных страниц).

SeoLik

С помощью сервиса SeoLik можно сделать полный анализ сайта по разным показателям, в том числе SEO. Чтобы запустить проверку, достаточно ввести доменное имя и нажать «Анализ». Сервис позволяет проверить:

CY-PR.com

CY-PR.com ― ещё один бесплатный сервис для экспресс-анализа показателей SEO. Регистрироваться не нужно, просто введите доменное имя и нажмите Анализировать:

Он будет полезен для анализа своего сайта и для анализа конкурентов. Кроме стандартных критериев оценки, CY-PR.COM предлагает:

измерение скорости работы сайта,

данные из WHOIS,

проверяет ошибки в кэшировании и CSS,

проверяет оптимизацию для мобильных устройств и планшетов.

Пиксель Тулс

Пиксель Тулс — универсальный анализатор сайта, который поможет узнать практически всё о ресурсе. Он простой в использовании, в бесплатной версии достаточно много инструментов для SEO-анализа. Сервис:

проверяет тексты на уникальность и вхождение ключевых слов,

проверяет позиции в Google и Яндекс,

показывает количество переходов из социальных сетей,

анализирует количество рекламных объявлений в выдаче Яндекса,

рассчитывает KPI,

анализирует ссылочную массу,

анализирует скорость загрузки контента.

В платной версии можно получить ещё больше возможностей, таких как анализ XML-карты, проверка поведенческих факторов пользователей, анализ SEO-тегов для списка URL и др. Можно настроить автоматический аудит.

Немного о Яндекс тИЦ

В интернете расположены миллионы ресурсов, которые имеют не только различный внешний вид и тематику, но и качество. Поисковый гигант рунета Яндекс ввел тематический индекс цитирования (тИЦ) для того, чтобы определять авторитетность того или иного сайта. Сам по себе индекс цитирования означает значимость работы ученого в научном мире. Величину этого индекса определяют количеством ссылок на данную работу, оставленных в других работах или источниках.

Аналогичной системой является и тИЦ поисковика Яндекс. Величина данного показателя определяется благодаря разработанному алгоритму, и зависит, не только от количества ссылающихся сайтов, но и от их тематики и качества. Каждая ссылка передает определенный «вес», зависящий от параметров ссылающегося ресурса. Соответственно, вес одной ссылки качественного ресурса может быть значительно больше, нежели вес нескольких менее авторитетных площадок.

Существует ряд сервисов, которые позволяют быстро проверить тИЦ онлайн. Рассмотрим наиболее популярные из них.

Яндекс.Вебмастер. В панели сервиса Яндекс.Вебмастер пользователь всегда может ознакомится с текущим показателем индекса цитируемости. Также в соответствующем окне можно проверить историю тИЦ, проследить на подробном графике информацию об изменении показателя.

Mainspy.ru, Webmasters.ru, Seolib.ru – три практически одинаковых сервиса, которые позволяют проверить тИЦ сайта. Следует отметить, что все три сервиса предоставляют возможность пользователю проверять до соответственно 50, 50, 20 доменов одновременно. Mainspy и Webmasters проводят проверку очень быстро, однако выдают лишь информацию о показателях. Сервис Seolib осуществлят проверку медленнее, но выдает дополнительную информацию о количестве страниц в ПС, наличии ресурса в каталоге Яндекса или Dmoz, а также дату регистрации домена.

Seo-monster.ru, Cy-pr.com, Pr-cy.ru – еще одна тройка схожих сервисов, которая отличается своим подходом проверки. Проверить одновременно можно только один домен. Но при проверке данные сервисы выдают подробнейшую информацию о сайте, включая количество страниц в индексе поисковика, текущие показатели и их историю, количество внешних ссылок и прочие данные. Каждый из сервисов, естественно, имеет свои «изюминки» и различия, но, с нашей точки зрения, наиболее удобным является Pr-cy.ru ввиду наличия более подробной информации и истории показателей.

Сервисы анализа трафика

Данные сервисы предназначены для оценки трафика сайта, его источников, поведения пользователей на вашем сайте. С их помощью также можно проанализировать эффективность рекламных кампаний и многое другое.

Яндекс.Метрика

Анализирует источники переходов и конверсий на сайте, трафик с поисковых систем и социальных сетей, рекламный трафик. Изучает информацию о посетителях — географию, коммерческие интересы, пол и возраст, а также поведение пользователей на сайте с помощью инструмента Вебвизор.

Google Analytics

Продвинутый и многофункциональный инструмент для веб-аналитики. Самый популярный инструмент для анализа трафика в интернете.

Существенный недостаток для рунета — нет информации о ключевых словах большей части поискового трафика из Яндекса, поскольку он шифрует HTTP referrer для всех сервисов статистики, кроме собственной Метрики.

Рекомендуем настроить доступ к данным Search Console в Google Analytics.

Google Tag Manager

Полезный инструмент, который помогает размещать на сайте необходимые коды счётчиков, отслеживания конверсий и тому подобные элементы. Вы устанавливаете на сайт код диспетчера тегов Google, а всё остальное добавляете уже через его интерфейс (не внося правки в код сайта).

5 Экономия личного времени пользователя

Пользователь интернета в поисках необходимой информации зачастую проводит много времени за компьютером, планшетом, телефоном. Поисковик может «подсовывать» человеку разные сайты-посредники, либо даже мошеннические сайты.

О связи между фейками и официальным сайтом

Фейки являются ложной информацией, которая распространяется в сети весьма быстро. Если пользователь не хочет способствовать распространению фейков в сети, ему нужно проверять по возможности информацию на официальном сайте. Цитировать информацию или давать на нее ссылки также лучше именно с официальных сайтов.

В общем, перепостить информацию с официального сайта – это одно дело. Тут владелец официального сайта с большой долей вероятности отвечает за выложенные в сети сведения. Перепосты с других неофициальных ресурсов – это зачастую распространение непроверенной информации. Обычно пересказывают понравившуюся информацию, а не достоверную, актуальную и надежную.

Какая информация должна быть на официальном сайте

Основные сведения, которые обычно представлены на официальных сайтах, перечислены ниже.

1 Логотип или товарный знак компании;

2 Услуги, товары, цены;

3 Подробное описание предлагаемых услуг, товаров;

4 Обратная связь, чтобы можно было связаться с представителем компании разными способами: телефон (звонки часто бывают бесплатными для клиента по номеру 8-800-…), электронная почта, онлайн-чаты с консультантами;

5 Контактные данные компании, включая ее ИНН, КПП, ОГРН и прочие реквизиты, зарегистрированные в официальных реестрах;

6 Сведения о компании, описание ее деятельности, миссия;

7 Поиск информации на сайте. Этот инструмента называется «поиск по сайту». С его помощью можно искать информацию в пределах данного официального сайта, а не по всему интернету, чтобы случайно в ходе поиска не «выпасть» в общую сеть с возможно недостоверной и непроверенной информацией;

8 Выбор языка, например, русского или английского. Международная поддержка языков необходима, если компания имеет зарубежные представительства или работает с клиентами из других стран.

Видеоформат статьи

Другие материалы:

1. Что такое экосистема в интернете на примерах Яндекса, Сбера и Mail ru

2. Ventusky: интерактивный сервис погоды вашего региона и всего мира

3. Как происходит сражение за пользователя между Google и Яндексом?

4. Какие бывают поисковые системы и как они работают?

5. Что такое пиратский контент, как он попадает в сеть и почему иногда исчезает?

Визуальная проверка сайта на мошенничества

Веб-сайты постоянно находятся под угрозой взлома. Взлом выполняется при помощи специально написанного автоматизированного скрипта. Его задача — «мониторить» интернет и пытаться взломать сайты, у которых есть известные уязвимости в программном обеспечении.

Целью большинства кибератак является несанкционированное использование сервера. Например, для хранения файлов нелегального содержания или спам-рассылок. Но есть и взломы, направленные на кражу данных пользователей. Для этого используются, в частности, фишинг-ресурсы (сайты, посадочные страницы).

Фишинговый сайт — это платформа для кибермошенничества. Такие ресурсы «заточены» под получение доступа к личной информации пользователей (данные платежных карт, логины и пароли, и т.д.). Это реализуется путем визуального копирования известных ресурсов — как правило, популярных. Например, сайта системы интернет-банкинга. Поэтому перед началом работы с сайтом (особенно если он вызывает даже малейшие подозрения) следует обезопасить себя. Сделать это можно несколькими способами.

Проверяем URL-адрес

Главная задача организатора фишинг-атак — сделать URL-адрес поддельного сайта максимально похожим на адрес оригинального ресурса. Злоумышленники рассчитывают на то, что невнимательный пользователь не обратит внимания на различия, ведь на первый взгляд URL фишингового сайта кажется подлинным. При тщательной проверке может оказаться, что буква l в адресе подменена цифрой 1, а домен заменен на .com вместо .ru.

Проверяем наличие протокола

Если домен сайта или страницы начинается с протокола HTTP, а не с HTTPS — ресурс, как минимум, не является безопасным, а как максимум — фишинговым, поскольку не поддерживает безопасное соединение. Убедитесь, что на навигационной панели браузера есть замок

Если он есть, ресурс использует надежный SSL (цифровая подпись сайта).

Важно знать и о том, что можно столкнуться с исключениями. Некоторые мошеннические ресурсы могут заполучить SSL-сертификат (в качестве подарка от конструктора сайтов или на тестовый период)

В таком случае наличие протокола HTTPS не является гарантией надежности ресурса — нужно обращать внимание на другие факторы и использовать

Проверка SSL сертификата

С помощью специальных сервисов (например, Regery и тому подобных) можно проверить дату выпуска сертификата и его срок действия, а также состояние правильности структуры кода (если это нужно, например, для рабочих целей). Проверка отобразит совместимость сертификата с браузерами, а также поможет выявить ошибки в его работе.

Этапы разработки функционала сайта

В создании функционала сайта советуем опираться на принцип разработки сайта, предложенный UX экспертом Джессом Гарреттом.

UX, то есть user experience, с английского переводится как «опыт пользователя» или «опыт взаимодействия». UX объединяет все, что можно реализовать с помощью функциональности и дизайна, чтобы привести пользователя к желаемой цели. UX — это про то, чтобы пользователю было удобно и приятно взаимодействовать с вашим сайтом. Чтобы посетитель сайта легко дошел до логической точки и совершил полезное действие, за которым он к вам обратился: получил необходимую информацию, узнал расписание работы компании, цену товара или оформил подписку. В свою очередь это полезное действие будет подводить пользователя к целевому действию для вас — покупке.

Джесс Гарретт предлагает разделить работу над функциональным наполнением сайта на пять уровней:

- Стратегию — описать цели и задачи сайта, изучить ЦА.

- Возможности — выяснить, какие функции помогают решать задачи пользователя.

- Структуру — спроектировать архитектуру сайта в зависимости от пользовательского опыта.

- Компоновку — подготовить прототип сайта.

- Поверхность — разработать дизайн сайта.

Такой метод мы и предлагаем использовать при разработке функционала сайта. Только, чтобы было удобней ориентироваться, мы скомпоновали эти уровни в несколько этапов: подготовка, проектирование функционала сайта и реализация.

Немного о Google PR

Google Page Rank (PR) — cхожий с Яндекс тИЦ показатель, который характеризует авторитетность определенной веб-страницы. Авторитет страницы зависит от переданного ей «веса» ссылающихся страниц. Передаваемый вес, естественно, зависит от авторитетности ссылающейся страницы.

Для вебмастеров была составлена примерная таблица зависимости PR от данного показателя ссылающихся страниц. Благодаря таблице можно вычислить приблизительное количество ссылок, необходимых для получения того или иного уровня PR. Например, для того, чтобы получить PR 4, необходима, как минимум, одна ссылка ресурса с показателем PR 5+ или, например, не менее сотни ссылок ресурсов с PR 2. Cледует отметить, что ссылки с тематических ресурсов дают больше веса, нежели нетематические. Аналогично, текст ссылки может влиять больше, нежели показатель ссылающейся страницы.

В целом, для того, чтобы посмотрть PR сайта можно использовать указанные выше ресурсы (Seo-monster.ru, Cy-pr.com, Pr-cy.ru, Webmasters.ru и прочие). Однако существует и ряд зарубежных сервисов, позволяющих быстро проверить PR страницы.

Prchecker.info, check-page-rank.net, whatsmypr.net – три достаточно схожих сервиса, которые позволяют быстро определить показатель Page Rank необходимой страницы. Первые два из них требуют ввода капчи.

Pagerankchecker.com и Checkpagerank.net – более информативные сервисы, которые показывают не только текущий PR проверяемой страницы, но и дополнительную информацию, включая количество обратных ссылок, наличие ресурса в каталогах, whois и прочее. Последний из сервисов дает возможность установки кнопки с показателем PR на свой сайт.

Немного об индексации сайта в поисковиках

Созданный недавно сайт не сразу можно найти в поисковых системах. Прежде чем он будет отображаться в них, роботы поисковых систем должны найти его, проанализировать содержимое и занести в свою базу данных. Только после этого проверенные (проиндексированные) страницы будут отображаться пользователям в поиске.

Уже проиндексированные ресурсы, обычно, не испытывают проблем с индексацией новых страниц. Однако о «свежих» сайтах поисковикам еще предстоит узнать. Произойти это может двумя способами.

Добавление сайта через определенную форму поисковика. Данный способ предполагает, что вы самостоятельно сообщите поисковой системе о новом сайте для его дальнейшей индексации. Следует добавлять только главную страницу, так как остальные будут автоматически проиндексированы по ссылкам.

Оставить индексацию ресурса поисковой системе. Для этого новому ресурсу необходимо получить хотя бы одну внешнюю ссылку с проиндексированного сайта. Именно по этой ссылке поисковый робот проиндексирует новый ресурс.

Узнать индексацию сайта в поисковых системах можно при помощи следующих сервисов.

Яндекс.Вебмастер – сервис поисковой системы Яндекс, который позволяет достаточно точно просмотреть текущее количество проиндексированных страниц собственного сайта. Также, в панели Вебмастер указано количество загруженных и исключенных из поиска страниц.

Google Webmastes – аналогичный сервис поисковой системы, позволяющий проверить индексацию сайта в Гугл. В панели инструментов для вебмастера можно увидеть подробный график с историей индексации страниц и показателем проиндексированных страниц на данный момент.

Кроме специализированных сервисов от поисковых систем существуют и прочие схожие системы. Среди них и наш сервис SE Ranking, который позволяет узнать число страниц в индексе для всех добавленных сайтов.

Не стоит забывать и о том, что для активного продвижения своего ресурса необходимо знать не только показатели тИЦ, PR и количество проиндексированных страниц, но и знать позиции, как своей площадки, так и сайтов конкурентов. Все эти данные с удовольствием демонстирует Вам SE Ranking. Регистрируйтесь в системе и в течение 14 дней тестируйте сервсис абсолютно бесплатно!

Просмотры:

8 830

Кристина Загорулько

Кристина — опытный копирайтер, пишет полезные статьи об IT, SEO и маркетинге. Cтарается нести актуальное и креативное в текстах.