Как скачать сайт целиком на компьютер? 8 лучших сервисов и программ

Содержание:

- Скачивание базы данных

- Настройка wget для загрузки всего сайта

- Как можно скачать сайт на компьютер полностью

- Сохранение картинок и шрифтов

- Скриншот

- Как сохранить страницу и картинку из интернета в браузере Mozilla Firefox

- Скопировать из браузера

- Использование онлайн-сервисов

- 3 метод. Специализированные программы

Скачивание базы данных

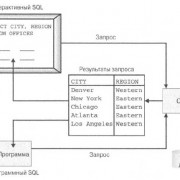

Базы данных – это неотъемлемая часть любого современного сайта. Обычно используется одна база данных MySQL. Сделать бекап базы данных можно разными способами, например, при помощи плагина для CMS. Но это не лучший вариант, использовать лишние модули, которые к тому же могут делать бекапы с ошибками. Итого, скачать базу данных сайта можно следующими способами:

- специальный инструмент – phpMyAdmin или аналогичный;

- резервные копии баз данных на хостинге.

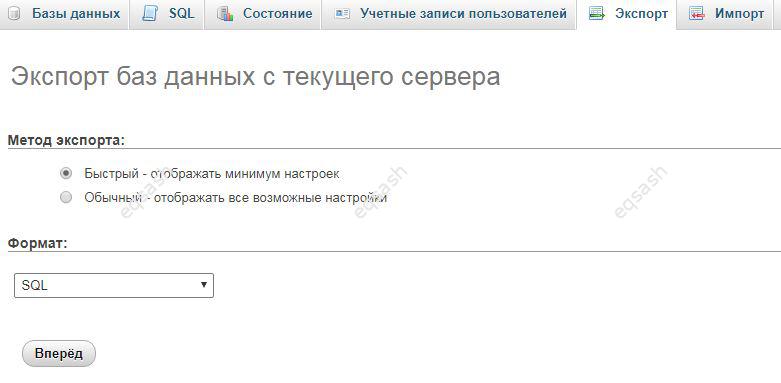

скачивания базы данных в phpMyAdmin

Откроется страница, где можно выбрать тип экспорта: быстрый — отображать минимум настроек, обычный — отображать все возможные настройки. После выбора типа экспорта остается нажать кнопку подтверждения и начнется процесс скачивания базы данных. Если база объемная – процесс может быть долгим, поэтому возможно стоит выбрать обычный режим экспорта и указать архивирование или сжатие базы данных (zip, gzip и т.д.).

Ну и наконец, можно скачать базу данных из резервных копий в панели управления хостингом. Обычно предоставляются готовые архивы за последнее время, но может понадобится моментальная копия базы в текущее время или необходимо гибко настроить экспорт – в таком случае данный способ не подойдет и придется использовать специальные инструменты, речь о которых шла выше.

Как видно, скачать файлы сайта и его базу данных по силам каждому специалисту, но у обычных пользователей могут возникнуть сложности. Поэтому советы из этой статьи помогут в их решении. Также Вы всегда можете обратиться за помощью.

← Разработать систему управления образованием для школы, СУЗа, ВУЗа или другого заведения

Как организовать удаленную работу или дистанционное обучение →

Настройка wget для загрузки всего сайта

Большинство настроек имеют короткую версию, но я не собираюсь их запоминать или вводить. Более длинное имя, вероятно, более значимое и узнаваемое. Я выбрал эти конкретные настройки из подробного руководства по wget, так что вам не нужно погружаться слишком глубоко, так как это относительно длинное чтение. Проверьте официальное описание этих настроек, если хотите, так как здесь я только разделяю свое мнение и почему я их выбрал

В порядке важности, вот они

Настройки для использования

Это набор других специфических настроек, все, что вам нужно знать, это волшебное слово, которое позволяет бесконечное сканирование рекурсии. Звучит необычно? Потому что это! Без этого вы не сможете скачать весь сайт, потому что у вас, вероятно, нет списка каждой статьи.

При этом wget загружает все ресурсы, на которые ссылаются страницы, такие как CSS, JS и изображения

Это важно использовать, иначе ваш архив будет очень поврежден

Это позволяет просматривать ваш архив локально. Это влияет на каждую ссылку, которая указывает на страницу, которая будет загружена.

Представьте, что вы сделали все возможное, чтобы загрузить весь веб-сайт, чтобы получить неиспользуемые данные. Если файлы не заканчиваются в своих естественных расширениях, вы или ваш браузер не сможете их открыть. В настоящее время большинство ссылок не содержат суффикс .html, хотя они должны быть .html файлами при загрузке. Этот параметр помогает вам открывать страницы, не размещая архив на сервере. Небольшое предостережение в том, что оно пытается быть умным, чтобы определить, какое расширение использовать, и оно не идеально. Если вы не используете следующую настройку, контент, отправляемый через gzip, может закончиться довольно непригодным расширением .gz.

Я обнаружил, что при работе с ресурсами, сжатыми gzip, такими как изображение SVG, отправленное сервером, это исключает возможность загрузки, такого контента как logo.svg.gz, который практически невозможно загрузить локально. Объединить с предыдущей настройкой

Обратите внимание, что если вы используете Unix, этот переключатель может отсутствовать в вашем wget, даже если вы используете последнюю версию. Подробнее на Как может отсутствовать сжатие в моем wget?

Боты могут сойти с ума, когда они достигают интерактивных частей веб-сайтов и находят странные запросы для поиска. Вы можете отклонить любой URL, содержащий определенные слова, чтобы предотвратить загрузку определенных частей сайта . Скорее всего, вы обнаружите только то, что должны были удалить после того, как wget потерпит неудачу хотя бы один раз. Для меня это породило слишком длинные имена файлов, и все это застыло. Хотя статьи на сайте имеют хорошие короткие URL-адреса, длинная строка запроса в URL-адресе может привести к длинным именам файлов. Регулярное выражение здесь является «основным» регулярным выражением POSIX.так что я бы не стал зацикливаться на правилах. Кроме того, это довольно сложно проверить методом проб и ошибок. Одна хитрость заключается в том, что шаблон / поиск будет даже соответствовать законной статье с URL yoursite.com/search-for-extraterrestrial-life или аналогичным. Если это проблема, то будьте более конкретны.

Я включаю его только когда сталкиваюсь с сервером, на котором wget жаловался на то, что мне следует использовать это. Я не собираюсь перезапускать процесс позже в той же папке, чтобы догнать текущий сайт. Следовательно, не имеет большого значения, как wget проверяет, изменились ли файлы на сервере.

Проверка сертификатов SSL не является критически важной задачей. Это предотвращает некоторые головные боли, когда вы заботитесь только о загрузке всего сайта без входа в систему

Некоторые хосты могут обнаружить, что вы используете wget для загрузки всего сайта и полностью блокируете вас. Спуфинг агента пользователя приятно замаскировать эту процедуру как обычного пользователя Chrome. Если сайт блокирует ваш IP, следующим шагом будет продолжение работы через VPN и использование нескольких виртуальных машин для загрузки стратифицированных частей целевого сайта (ой). Возможно, вы захотите проверить и варианты, если ваш сервер умный, и вам нужно замедлить и задержать запросы.

В Windows это автоматически используется для ограничения символов файлов архива безопасными для Windows. Однако, если вы работаете в Unix, но планируете просмотреть позже в Windows, то вы хотите явно использовать этот параметр. Unix более простителен для специальных символов в именах файлов .

Стоит упомянуть, поскольку он будет сохранять оригинальную копию каждого файла, в который wget конвертировал ссылку . Это может почти удвоить ваш архив и требует очистки, если вы уверены, что все в порядке. Я бы не стал этим пользоваться.

Как можно скачать сайт на компьютер полностью

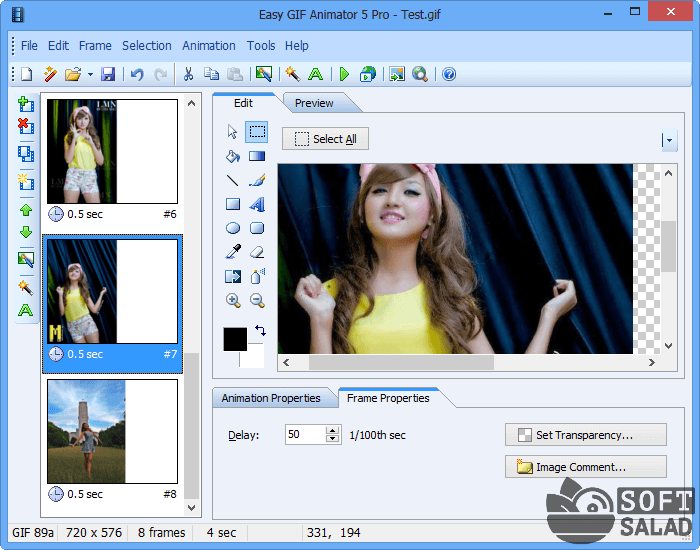

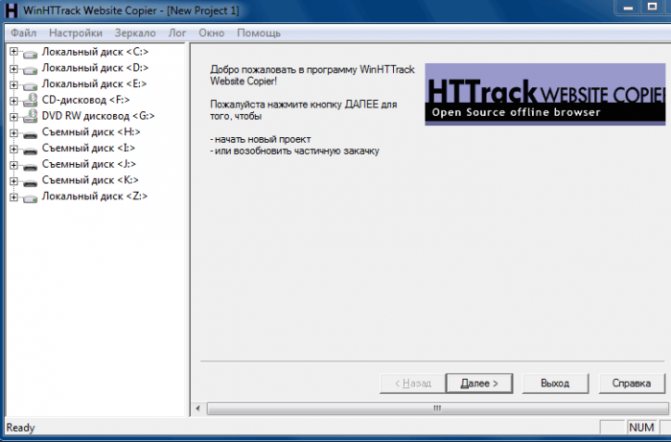

Процесс скачивания сайта целиком с помощью WinHTTrack я рассмотрю на примере своего ресурса, на котором вы сейчас находитесь.

Запускаем WinHTTrack и посередине экрана программы нажимаем на кнопку Далее >:

В новом окне указываем Имя нового проекта, Категорию проекта (для дальнейшего упорядочивания сохраненных сайтов) и путь сохранения — Каталог (где на компьютере будут храниться сохраненные сайты), который при желании можно изменить. Жмем Далее:

Причем у программы WinHTTrack Website Copier есть хорошая особенность. В ней можно в реальном времени наблюдать процесс скачивания сайта целиком. И при этом можно пропускать скачивание любых ненужных файлов:

Это может быть полезно, когда мы видим, что качается какой-нибудь большой видео-файл или ненужная нам программа.

Но можно также изначально (перед скачиванием сайта) задать параметры по своему желанию, чтобы, например, заранее исключить скачивание того, что нам не нужно.

Такую настройку параметров давайте рассмотрим немного подробнее.

А). Фильтры WinHTTrack для скачивания сайта

В данной вкладке можно дать задание программе: как при скачивании сайта поступать с некоторыми файлами.

Допустим, нам нужно скачать сайт целиком вместе со всеми картинками. При этом нам не нужны программы (файлы exe), архивы, а также видео и аудио, которые могут находиться на ресурсе. В таком случае мы ставим на всех группах файлов галочки и меняем вручную значок + на – для всех файлов, которые хотим исключить из закачки:

Как видим, вариантов для скачивания необходимой информации может быть много.

Б). Ограничения WinHTTrack при копировании сайта

В этой вкладке можно настроить некоторые параметры, ограничивающие какие-либо функции. При наведении на каждую ячейку курсором мыши, появляется пояснение выбранного ограничения, поэтому можно посмотреть, что означает каждое из них:

Две из них, на мой взгляд, самые часто используемые:

Максимальный размер сайта. Полезно в случаях, когда мы хотим ограничить скачивания сайта, ведь мы не знаем, сколько там информации на самом деле, а место у нас на компьютере может быть ограничено. Поэтому сами решаем, сколько можем уделить места на своем компьютере для этого сайта.

Максимальное время закачки сайта. Полезно в случаях, когда мы куда-нибудь собираемся и выходить уже нужно через полчаса-час, а нам нужно срочно скачать какой-нибудь сайт в дорогу почитать без Интернета. И здесь можно указать время, через сколько прекратить закачку, т.е. сколько успеем скачать – сколько и будет.

Остальные ограничения можете попробовать использовать самостоятельно, — они уже не так часто применимы и, может быть, не понадобятся никогда.

В). Линки WinHTTrack

Рекомендую в этой вкладке поставить галочку: получить вначале HTML файлы, чтобы сначала загрузились страницы сайта, а уже потом все остальное (картинки, видео, аудио и т.д.):

Остальные вкладки дают дополнительные возможности, но основное, что нужно для того, чтобы скачать сайт целиком, я описал в этой заметке. Начинающему пользователю, думаю, на остальное можно не обращать особого внимания.

Вот и всё! Осталось нажать на кнопку Далее и Готово:

И после закачки сайта можно переходить к его просмотру.

Сохранение картинок и шрифтов

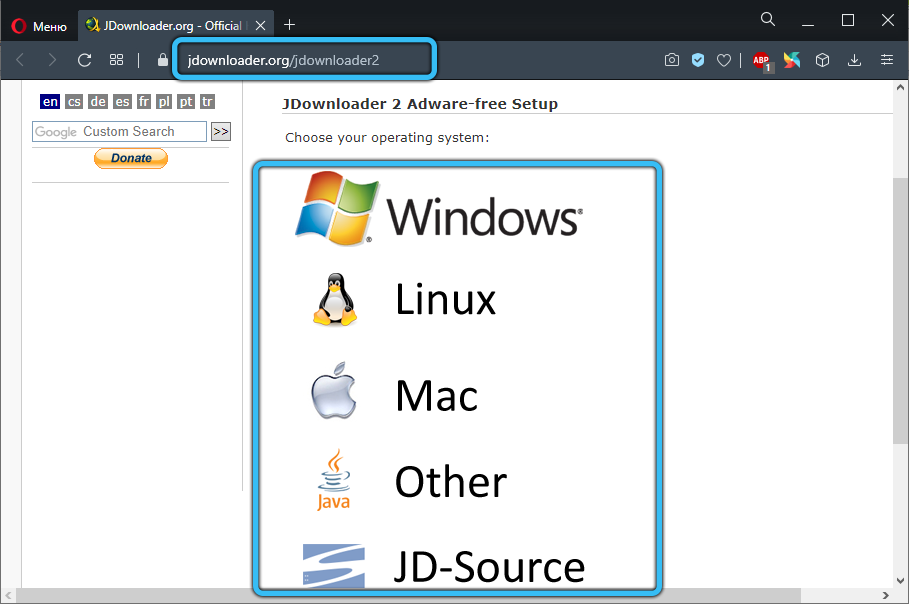

Помимо сервисов онлайн для скачивания интернет-сайтов, существуют и специальные программы для этого. Как и сервисы, они требуют наличия интернет соединения, но для работы им необходим только адрес сайта.

HTTrack WebSite Copier

Бесплатная программа с поддержкой русского языка, операционных систем, не относящихся к семейству Windows, а главное – бесплатная. В меню установки доступен только английский, однако уже при первом запуске в настройках есть возможность установить русский или любой другой. По умолчанию создает на системном разделе папку «Мои сайты», куда и будут сохраняться все загруженные интернет-порталы. Имеет возможность дозагрузить сайт, если по какой-то причине загрузка прервалась.

Главное окно программы HTTrack WebSite Copier

Также есть ряд настраиваемых параметров:

- тип контента – позволяет задавать доступность изображений, видео и прочих медийных составляющих;

- максимальная глубина скачивания – доля доступного функционала. Большинству сайтов подходит глубина – 3-4 уровня;

- очередность скачиванию – задает приоритет загрузки текста или медиа-файлов.

Возможно вас заинтересует: Как расшарить файлы и папки в локальной сети и интернет (общие папки)

К недостаткам можно отнести частично утративший актуальность интерфейс.

Использование:

- Скачать программу из надежного источника.

Скачиваем программу из официального источника

- Кликнуть «Далее», чтобы создать новый проект.

Нажимаем «Далее»

- Ввести имя, под которым будет находиться сохраненный сайт, выбрать путь для загрузки файла, нажать «Далее».

Вводим имя, под которым будет находиться сохраненный сайт, выбираем путь для загрузки, нажимаем «Далее»

- Задать адрес сайта и тип содержимого, которое будет загружаться.

Задаем адрес сайта и тип содержимого

- Настроить глубину загрузки — количество подразделов сайта, щелкнув по опции «Задать параметры».

Щелкаем по опции «Задать параметры»

- Во вкладке «Прокси» оставить настройки по умолчанию или убрать галочку с пункта «Использовать прокси…».

Во вкладке «Прокси» оставляем все по умолчанию

- В закладке «Фильтры» отметить флажками пункты, которые нужно исключить.

Во вкладке «Фильтры» отмечаем нужные пункты

- Перейти во вкладку «Ограничения» в полях задать максимум и минимум, как на скриншоте.

Во вкладке «Ограничения» выставляем значения максимальное и минимальное, как на фото

- Во вкладке «Линки» отметьте пункты, как на фото.

Отмечаем пункты, как на скриншоте

- Перейти во вкладку «Структура», в разделе «Тип структуры…» выбрать параметр «Структура сайта (по умолчанию)», нажать «ОК».

Во вкладке «Структура» выбираем в параметре «Тип…» структуру сайта по умолчанию, нажимаем «ОК»

- Выбрать тип соединения, при необходимости — выключение компьютера после завершения. Нажать «Готово».

Выставляем настройки, как на скриншоте, нажимаем «Готово»

- Дождаться завершения процесса скачивания.

Процесс скачивания сайта, ожидаем завершения

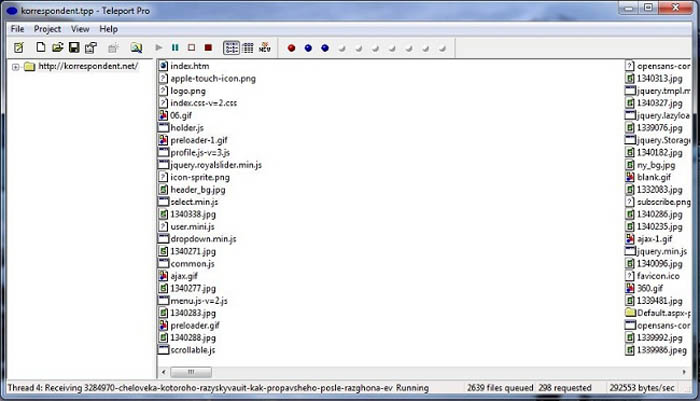

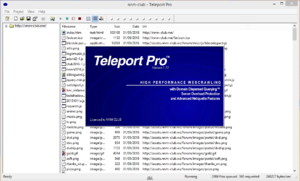

Teleport Pro

Программа с простым и понятным интерфейсам, дружелюбным даже для новичка. Способна искать файлы с определенным типом и размером, а также выполнять поиск, использую ключевые слова. При поиске формирует список из всех файлов со всех разделов ресурса. Однако, у нее хватает и недостатков. Главный из них – платная лицензия. 50 долларов далеко не каждому по карману.

Возможно вас заинтересует: Как поменять мак адрес компьютера

Интерфейс программы Teleport Pro

Кроме того в настройках отсутствует русский язык, что сделает еще более сложным пользование людям, не владеющим английским. Также эта программа несовместима с «альтернативными» ОС для обычных компьютеров (не «маков»), и в завершении «минусов» программы – она обладает очень старым интерфейсом, что может не понравиться людям, привыкшим работать на последних версиях Windows.

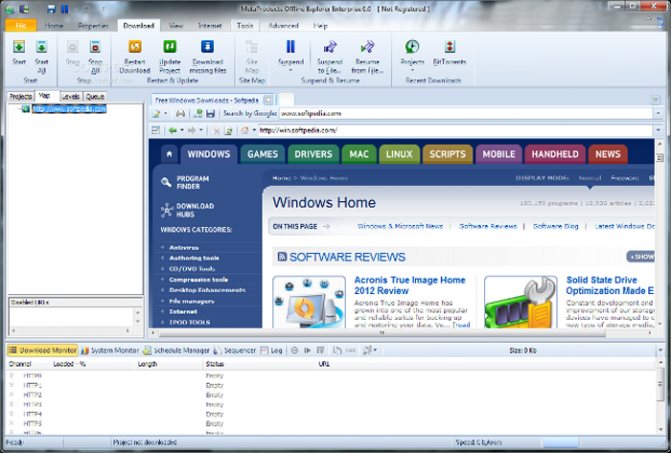

Offline explorer Pro

Интерфейс программы Offline explorer Pro

Еще одна лицензионная программа. По сравнению с упомянутыми выше, функционал значительно расширен: можно загружать даже потоковое видео, интерфейс более привычен для современных операционных систем. Может обрабатываться до 500 сайтов одновременно, включая запароленные. Программа имеет собственный сервер, что делает ее гораздо автономней прочих программ, не говоря уже об онлайн-сервисах. Позволяет переносить сайты прямиком из браузера.

Главный недостаток большая цена: 60 долларов за стандартную версию, 150 – за профессиональную и целых 600 – за корпоративную. Такие цены делают ее доступной только для узкого круга пользователей.

Скриншот

Снимок экрана — это самый простой способ добавить какую-то информацию на компьютер. Она сохраняется в виде графического файла. Его можно открыть и просмотреть в любое время. Вот как сделать скрин:

- Зайдите на нужный портал.

- Нажмите на клавиатуре кнопку PrintScreen (иногда она называется «PrntScr» или «PrtSc»). Снимок экрана будет добавлен в буфер обмена — временное хранилище, используемое при операциях «Копировать-Вставить».

- Откройте любой графический редактор. В операционной системе Windows есть свой — называется «Paint». Можете воспользоваться им. В нём можно обрезать и немного подкорректировать скриншот. Для более серьёзного редактирования графики надо устанавливать на компьютер профессиональные программы (Adobe Photoshop, к примеру). Но чтобы просто сделать копию страницы, хватит и собственных средств Windows.

- Вставьте скрин в редактор. Для этого нажмите Ctrl+V.

- Можно добавить его и в текстовый процессор (тот же Word), который поддерживает работу с графикой.

Получить снимок страницы можно с помощью графических редакторов. Например, Paint.

Информация будет представлена в виде сплошной картинки, а не набора символов. Если понадобится скопировать какую-то часть материала, придётся перепечатывать его вручную. Ведь скриншот — не статья. Чтобы облегчить задачу, воспользуйтесь утилитами для распознавания текста с рисунков.

Так удобно копировать небольшие куски. Но вот с объёмным контентом сложнее. Придётся делать много снимков, прокручивать, часто открывать редактор. Но можно разобраться, как сделать скрин всей страницы портала, а не её части. Используйте специализированные программы.

Утилиты для создания скриншотов

Существуют программы для работы со снимками экрана. С их помощью можно охватить контент полностью, а не скринить по кускам.

- Популярное приложение с разнообразным функционалом.

- Расширение для веб-браузера. Можно сделать картинку всей страницы, просто нажав кнопку на панели инструментов.

- Снимает всё, что можно снять: произвольные области, окна, большие веб-ресурсы. Есть инструментарий для редактирования получившихся изображений и библиотека эффектов.

- Автоматически прокручивает, делает серию кадров и самостоятельно объединяет их в один скриншот.

Есть также онлайн-сервисы, которые могут сформировать снимок. Они работают по одному принципу: вставить адрес сайта — получить картинку. Вот некоторые из них.

- Capture Full Page

- Web Screenshots

- Thumbalizr

- Snapito

Как сохранить страницу и картинку из интернета в браузере Mozilla Firefox

В браузере Mozilla Firefox найдите сверху раздел меню «Файл». Нажмите на него. В открывшейся вкладке найдите и нажмите на пункт «Сохранить как…»:

Указать место, куда нужно сохранить файл. В «Тип файла» укажите, как бы вы хотели сохранить страницу:

Нажмите «Сохранить». Если вы не можете найти раздел меню «Файл», значит нужно его включить. Для этого выполните такие действия: кликните правой кнопкой мыши по пустому полю вверху браузера. Появится меню. Выберите в том меню пункт «Панель меню».

Как сохранить текст из интернета?

Это самый примитивный, но работающий способ сохранения текста с интернета. Итак, выделите мышкой текст, который нужно сохранить. После того, как вы выделили текст, нажмите на клавиатуре сочетание клавиш «Ctrl» + «С» — копировать. Откройте любой текстовый редактор: блокнот, Microsoft Word или WordPad. Нажмите сочетание клавиш на клавиатуре «Ctrl» + «V» — вставить.

Таким способом можно не только сохранять тексты в интернете, но и картинки.

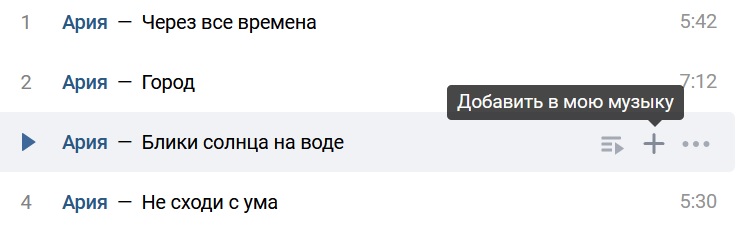

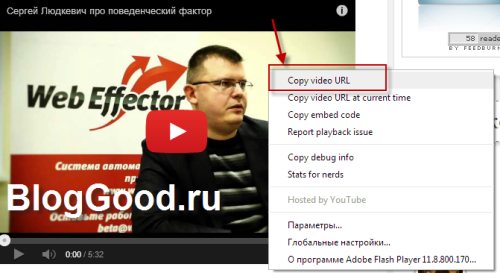

Как сохранить видео из интернета?

Как-то давно я писал в своем блоге о том, как сохранить видео из YouTube. Давайте, теперь я расскажу, как сохранить видео из интернета, точнее с сайта. Принцип действия тот же, что при скачивании видео с ютюба. Ладно, не буду болтать лишнего, приступим к делу.

Нажмите правой кнопки мыши по видео, которое размещено на сайте. В открывшейся вкладке нажмите на «Скопировать URL (Copy video URL)».

Теперь открывайте новую вкладку браузера и нажатием клавиш на клавиатуре «Ctrl» + «V» вставьте адрес видео в адресную строку.

Вам только осталось в самом начале адреса добавить две английские буквы «ss».

Например: было так — https://youtube.com/куча символов а стало во так — https://ssyoutube.com/куча символов

И все, качаем с хостинга. Это все. Надеюсь, статья о том, как сохранить страницу или видео с интернета была вам полезной. Если была, жмите снизу на кнопки социальных сетей.

Скопировать из браузера

Можно перенести данные из обозревателя в любой текстовый редактор. Для этого лучше всего подойдёт Microsoft Word. В нём корректно отображаются изображения и форматирование. Хотя из-за специфики документа может не очень эстетично выглядеть реклама, меню и некоторые фреймы.

Вот как скопировать страницу сайта:

- Откройте нужный URL.

- Нажмите Ctrl+A. Или кликните правой кнопкой мыши по любой свободной от картинок и flash-анимации области и в контекстном меню выберите «Выделить». Это надо сделать для охвата всей информации, а не какого-то произвольного куска статьи.

- Ctrl+C. Или в том же контекстном меню найдите опцию «Копировать».

- Откройте Word.

- Поставьте курсор в документ и нажмите клавиши Ctrl+V.

- После этого надо сохранить файл.

Иногда получается так, что переносится только текст. Если вам нужен остальной контент, можно взять и его. Вот как скопировать страницу веб-ресурса полностью — со всеми гиперссылками, рисунками:

- Проделайте предыдущие шаги до пункта 4.

- Кликните в документе правой кнопкой мыши.

- В разделе «Параметры вставки» отыщите кнопку «Сохранить исходное форматирование». Наведите на неё — во всплывающей подсказке появится название. Если у вас компьютер с Office 2007, возможность выбрать этот параметр появляется только после вставки — рядом с добавленным фрагментом отобразится соответствующая пиктограмма.

Способ №1: копипаст

В некоторых случаях нельзя скопировать графику и форматирование. Только текст. Даже без разделения на абзацы. Но можно сделать скриншот или использовать специальное программное обеспечение для переноса содержимого страницы на компьютер.

Сайты с защитой от копирования

Иногда на ресурсе стоит так называемая «Защита от копирования». Она заключается в том, что текст на них нельзя выделить или перенести в другое место. Но это ограничение можно обойти. Вот как это сделать:

- Щёлкните правой кнопкой мыши в любом свободном месте страницы.

- Выберите «Исходный код» или «Просмотр кода».

- Откроется окно, в котором вся информация находится в html-тегах.

- Чтобы найти нужный кусок текста, нажмите Ctrl+F и в появившемся поле введите часть слова или предложения. Будет показан искомый отрывок, который можно выделять и копировать.

Если вы хотите сохранить на компьютер какой-то сайт целиком, не надо полностью удалять теги, чтобы осталась только полезная информация. Можете воспользоваться любым html-редактором. Подойдёт, например, FrontPage. Разбираться в веб-дизайне не требуется.

- Выделите весь html-код.

- Откройте редактор веб-страниц.

- Скопируйте туда этот код.

- Перейдите в режим просмотра, чтобы увидеть, как будет выглядеть копия.

- Перейдите в Файл — Сохранить как. Выберите тип файла (лучше оставить по умолчанию HTML), укажите путь к папке, где он будет находиться, и подтвердите действие. Он сохранится на электронную вычислительную машину.

Защита от копирования может быть привязана к какому-то js-скрипту. Чтобы отключить её, надо в браузере запретить выполнение JavaScript. Это можно сделать в настройках веб-обозревателя. Но из-за этого иногда сбиваются параметры всей страницы. Она будет отображаться неправильно или выдавать ошибку. Ведь там работает много различных скриптов, а не один, блокирующий выделение.

Если на сервисе есть подобная защита, лучше разобраться, как скопировать страницу ресурса глобальной сети другим способом. Например, можно создать скриншот.

Использование онлайн-сервисов

Онлайн-ресурсы для сохранения страниц в браузере — самый простой способ того, как скопировать сайт. Это не только быстро, не требует установки дополнительного ПО на ваш компьютер и это бесплатно. Нужно всего-лишь зайти на интересующий вас ресурс, ввести в отведенное для этого места адрес сайта, запустить скачивание и выбрать место, куда это будет скачиваться.

Есть бесплатные и платные ресурсы. Платных намного больше и они удобнее, а бесплатных не так много, иногда они работают очень медленно, но для простого пользователя будут полезными, особенно если вы не часто скачиваете сайты. Для того, чтобы вам было понятнее, предлагаем подробнее рассмотреть бесплатные онлайн-сервисы.

Webparse.ru

Этот ресурс можно только условно назвать бесплатным. Им очень удобно пользоваться и он хорошо и быстро скачивает сайт, но бесплатно это можно сделать только один раз, потом за использование ресурса придется платить. Но если ситуации, когда вам нужно скачать сайт целиком и сделать это максимально быстро и удобно, у вас случаются очень редко, советуем воспользоваться данным сайтом.

Основное его преимущество в том, что он работает практически молниеносно и если вам очень нужно скачать сайт и быстрее уходить из дома туда, где не будет доступа к интернету, такой вариант очень хорошо подойдет. После скачивания сайта у вас в загрузках будет висеть архив с этой информацией. Однако сайт может скачаться не полностью, особенно, если у него очень большая структура. Поэтому если вы подозреваете, что не все могло скачаться, то разархивируйте папку и посмотрите, есть ли там та информация, которая нужна вам. И если нет — скачайте постраничным сохранением.

Web2PDFConvert.com

Есть и другие способы сохранения сайтов на свой компьютер с помощью онлайн-ресурсов. Так, удобно пользоваться Web2PDFConvert.com. Он создаст PDF-файл, в котором будут страницы необходимого сайта. Конечно, часть функция (таких как гиперссылки, например), вы потеряете, но если сайт вам нужен только для текстовой информации, то им пользоваться удобно. Самое главное, что скачивается все быстро и бесплатно.

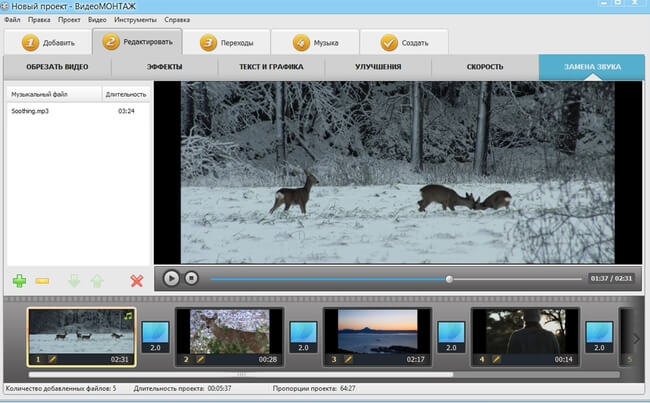

3 метод. Специализированные программы

Специальные утилиты для скачивания сайтов довольно неплохо справляются со своей задачей. К сожалению, и здесь не обходится без платных версий, но бесплатные (которые иногда называют оффлайн-браузерами) практически не уступают по возможностям платным аналогам.

По сравнению с онлайн-сервисами такие программы работают гораздо быстрее. Но придётся поискать подходящую версию программного обеспечения под вашу операционную систему. Некоторые программы могут работать не только с Windows, но и с другими операционными системами. Познакомимся с некоторыми из таких программ:

WinHTTrack WebSite Copier

Очень популярная бесплатная программа, предназначенная для копирования целых сайтов. Скачать можно на официальном сайте http://www.httrack.com/page/2/en/index.html.

Очень популярная бесплатная программа, предназначенная для копирования целых сайтов. Скачать можно на официальном сайте http://www.httrack.com/page/2/en/index.html.

После этого вводим адрес выбранного сайта. В настройках задаём глубину просмотра, определяем фильтры, которые указывают что необходимо скачать. Можно определиться и с другими настройками — их достаточно много. После чего нажимаем кнопку «Готово» и ждём окончания процесса.

По завершении скачивания файлы сайта будут находиться в указанной папке. Чтобы его просмотреть нужно выбрать стартовый файл index.htm. Теперь сохранённый проект можно скачать на любой электронный носитель и пользоваться им по необходимости.

dollysites.com

Программа с простым интерфейсом, где сложно запутаться. После скачивания подходящей версии с сайта разработчика нужно установить и запустить утилиту. Выберите язык, где присутствует и русский, укажите категорию проекта и его имя, а также место сохранения скачиваемого сайта. Остальное дело техники.

Cyotek WebCopy

Программа с большими возможностями различных настроек процедуры скачивания сайта. Утилита англоязычная (русский отсутствует), но с отличным интерфейсом. Достаточно ввести адрес выбранного вами сайта, указать место для сохранения и воспользоваться кнопкой Copy Website. После скачивания из указанного места сохранения запустить начальную страницу ресурса index.htm.

Недостатки, которые заключаются в отсутствии русификации и в ограничении работы с разными операционными системами (работает только с Windows) никак не умаляют достоинства этой программы.

Teleport Pro

Программа проверена временем. Но к сожалению, платная. Имеет временной тестовый период. После установки нужно запустить программу и указать в главном окне режим скачивания сайта. Можно сохранять не только полную копию, но и определённые типы файлов. Для создания проекта нужно ввести адрес выбранного сайта, указать место сохранения и обозначить глубину переходов по страницам. Процедура скачивания начнётся после нажатия на кнопку Start из панели управления.

Программа проверена временем. Но к сожалению, платная. Имеет временной тестовый период. После установки нужно запустить программу и указать в главном окне режим скачивания сайта. Можно сохранять не только полную копию, но и определённые типы файлов. Для создания проекта нужно ввести адрес выбранного сайта, указать место сохранения и обозначить глубину переходов по страницам. Процедура скачивания начнётся после нажатия на кнопку Start из панели управления.

Offline Explorer

Довольно функциональная, но тоже платная программа. Имеется русифицированная версия с тестовым периодом 30 дней. Существует количественное ограничение на скачиваемые файлы — 2000.

Создание нового проекта начинается тоже с указания адреса интересующего веб-ресурса. После фиксации всех настроек и определения параметров загрузки можно смело жать на кнопку «Загрузить» и спокойно дожидаться результата.

Webcopier

Программа платная с тестовым периодом 15 дней. Алгоритм создания проекта аналогичен предыдущим. Для начала скачивания выбранного сайта нужно воспользоваться кнопкой Start download. Сам процесс будет отображаться при помощи графика, который покажет скорость работы и время скачивания.